最近公開されたオープンソースのLlama3 8Bモデルの記憶力テストの結果が注目を集めています。このテストによると、Llama3 8Bは最大100,000トークンまでの情報を記憶することができ、忘却することなく情報を保持する能力を有していることが明らかになりました。これは、言語モデルが長期記憶をどの程度維持できるかを示す重要な指標です。

従来、多くのクローズソースモデルは、大量のパラメータと複雑なアーキテクチャを用いて、より長いトークンシーケンスに対する情報処理の質を向上させることに焦点を当ててきました。しかし、最近ではオープンソースのAIモデルが注目されるようになり、その開発のトレンドに変化が見られます。具体的には、軽量なモデル(パラメータ数が少ない)、そこそこのパフォーマンスを持つモデルへの関心が高まっており、必要に応じて追加のトレーニングを施すことでカスタマイズが可能です。

このような変化は、AI技術の実用化が進むにつれて、特にビジネスの現場でAIを導入する際の考慮事項が変わってきていることを反映しています。以前はできるだけ高性能なAIを試すことに重点を置いていましたが、実際のビジネス運用を考えた場合、セキュリティの問題、必要なハードウェアの選定、モデルのチューニングのしやすさなど、さまざまな要素が重要なポイントとなってきています。したがって、これらの要素を考慮に入れたモデル選びが、より重要視されるようになっているのです。

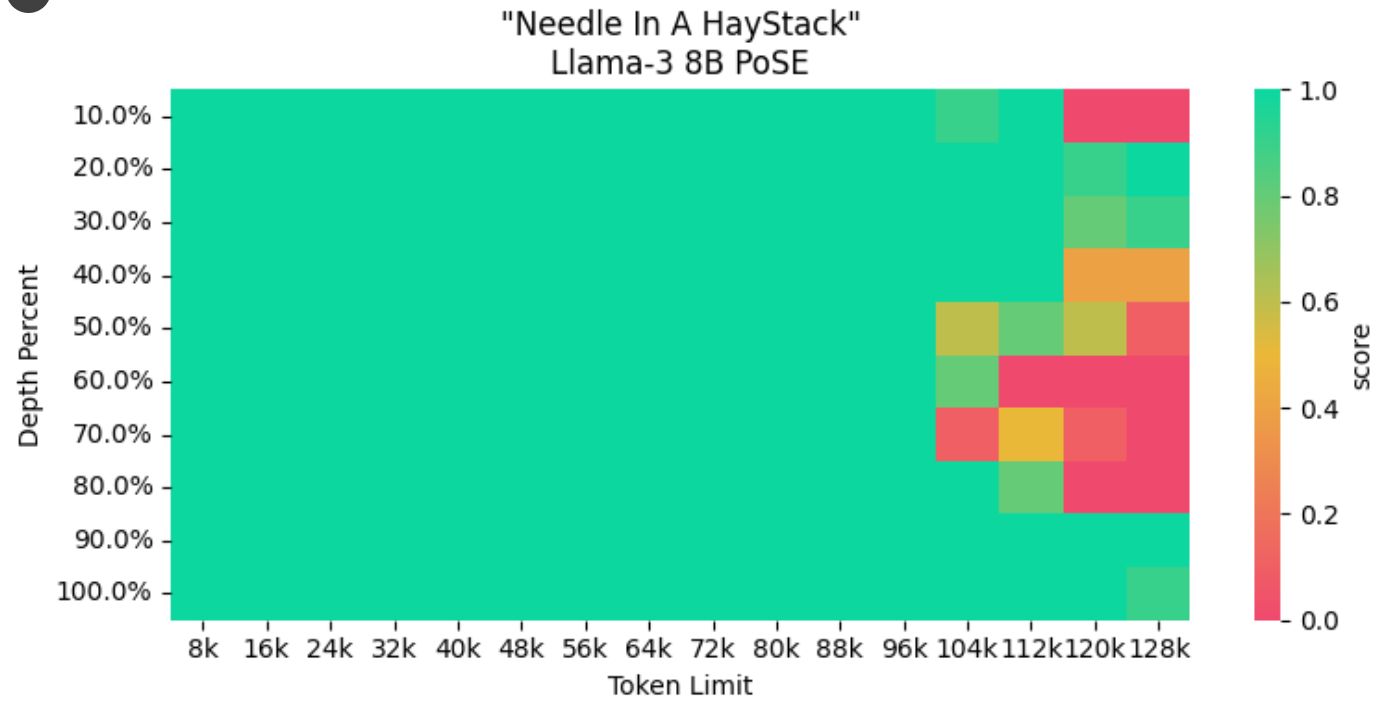

Llama-3 8B PoSEモデル

Llama-3 8B PoSEモデルは、Gradient.aiとCrusoe AIによって開発された大規模言語モデル(LLM)です。このモデルは、従来のLLMよりも長いテキストを処理できるよう、PoSEと呼ばれる技術を採用しています。GPT4に比べると小規模です。

モデルの主な特徴

パラメータ数: 80億個

処理できる最大トークン数: 128,000トークン (実際は100,000くらいまで、記憶の忘却なしで使用できると思われる)

主なタスク

* テキスト生成

* 言語翻訳

* 要約

* 問答応答

* コード生成

* PoSE技術

PoSE技術の詳細

PoSE技術は、「Position-wise State Embedding」の略称です。この技術は、モデルの各層に位置情報を埋め込むことで、長いテキストを処理できるようにします。位置情報により、モデルは長い文章の中でも、文脈を理解しやすくなります。

Llama-3 8B PoSEモデルの利点

* 従来のLLMよりも長いテキストを処理できる

* 高い精度でさまざまなタスクを実行できる

* さまざまなクリエイティブなテキスト形式を生成できる

* 大規模なハードスペックを必要としないので、自社の専用AIとして使用できる