はじめに

2026年、AIアシスタントは私たちの日常に欠かせない存在となりました。しかし、多くのAIサービスは「クラウド型」であり、私たちの質問や会話内容はすべてインターネット経由で企業のサーバーに送信されています。そんな中、Gensparkが発表した「オンデバイスAI」は、完全に自分のパソコン内でAIを動作させる革新的なアプローチです。

Genspark オンデバイスAIとは?

Genspark オンデバイスAIは、AIモデルを完全に自分のパソコン上で実行する技術です。通常のChatGPTやClaude、Geminiなどのクラウド型AIサービスとは異なり、一度モデルをダウンロードすれば、インターネット接続なしでAIと対話できます。尚、「Genspark オンデバイスフリーAI」という記述される場合もあります。全く同じモデルです。技術を話す場合は「Genspark オンデバイスAI」、マーケティングの話をする場合は、「Genspark オンデバイスフリーAI」と使い分けているようです。

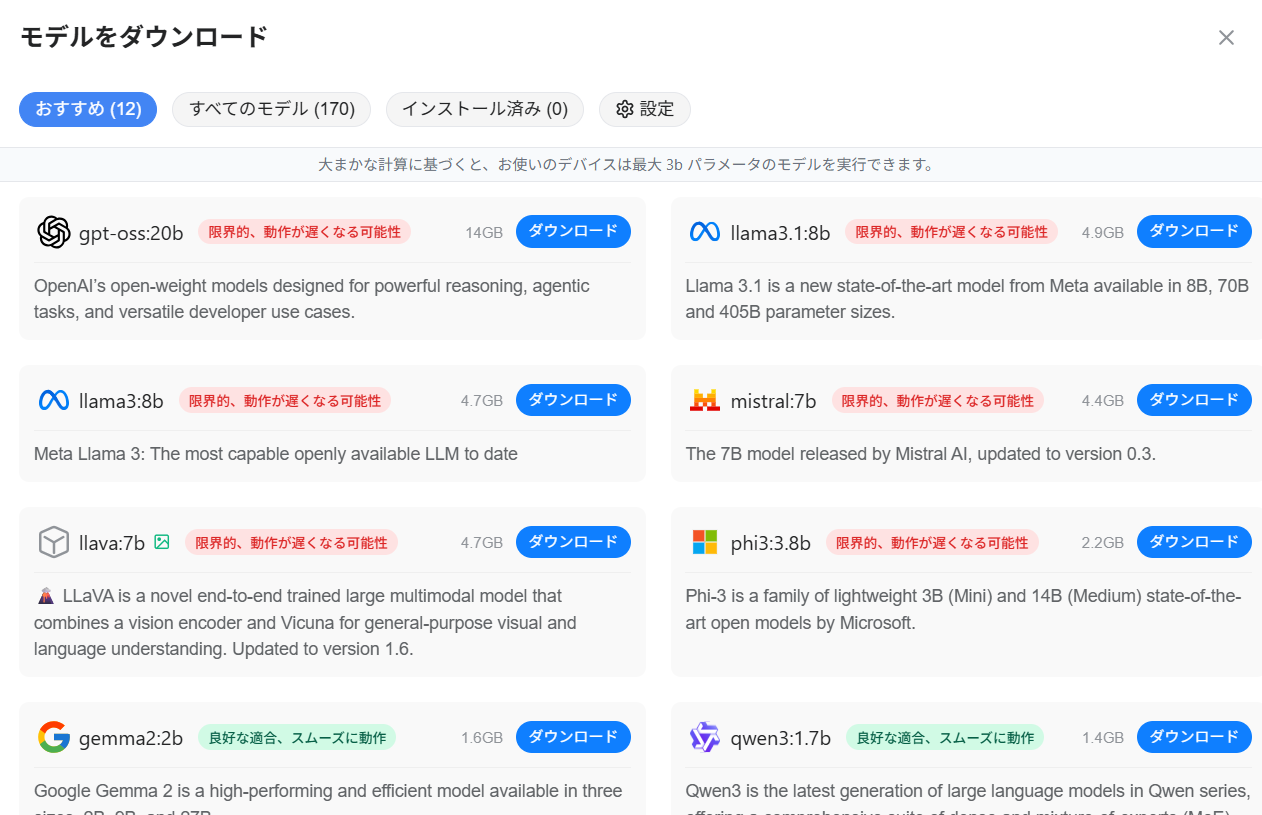

選べる170のオープンウェイトモデル

Gensparkでは、以下のような多様なAIモデルから選択できます:

- GPT系モデル (gpt-oss:20b など)

- Meta Llama (llama3.1:8b, llama3:8b など)

- Mistral AI (mistral:7b など)

- Google Gemma (gemma2:2b など)

- Microsoft Phi (phi3:3.8b など)

- Alibaba Qwen (qwen3:1.7b など)

- マルチモーダルモデル (llava:7b - 画像理解可能)

モデル名の後ろの数字(例:8b、2b(bは10億))は「パラメータ数」を示し、これが大きいほど高性能ですが、より多くのメモリを必要とします。

この画面でお使いのPCの性能にあわせてどのAIが使えるかを見て「おすすめ」を判断します。私のPCは低スペックなので高度なモデルは動作しません。(ソフトウエアをインストール時にPCスペックを見てgensparkが判断します。

オンデバイスAIの5つの大きなメリット

1. 完全なプライバシー保護 🔒

あなたのデータは一切外部に送信されません。

クラウド型AIでは、あなたの質問内容はすべて企業のサーバーに記録されます。たとえ「プライバシーポリシー」で保護されていても、以下のリスクは存在します:

- データ漏洩のリスク

- 企業による学習データとしての利用

- 政府機関による情報開示要求

- サービス規約の変更による影響

オンデバイスAIなら、自分のパソコンから物理的にデータが出ることはありません。医療情報、財務情報、企業機密など、センシティブな内容でも安心して相談できます。

2. インターネット不要 ✈️

一度モデルをダウンロードすれば、完全オフラインで動作します。

こんなシーンで威力を発揮:

- 飛行機の機内

- 海外出張先(ローミング料金を気にせず)

- インターネット環境が不安定な場所

- カフェの公衆Wi-Fiに接続したくないとき

- 通信制限を気にせず使いたいとき

3. 超高速レスポンス ⚡

サーバーとの通信が不要なため、応答速度が圧倒的に速いです。

クラウド型AIの場合:

質問 → インターネット送信 → サーバーで処理 → 結果を受信

(合計:数秒〜数十秒)

オンデバイスAIの場合:

質問 → PC内で処理 → 即座に結果

(合計:0.5秒〜数秒)

特に、短い質問やシンプルなタスクでは、その差は歴然です。

4. 完全無料 💰

サブスクリプション、使用制限、追加料金が一切ありません。

- ChatGPT Plus: 月額20ドル(約3,000円)

- Claude Pro: 月額20ドル

- Gemini Advanced: 月額19.99ドル

これらの費用が、オンデバイスAIでは永久に無料です。電気代以外のコストはかかりません。

5. 検閲・制限なし 🗣️

クラウド型AIには、企業ポリシーによる「使えない質問」が存在します。オンデバイスAIは、オープンウェイトモデルを使用しているため、自分のパソコン内で自由に使えます。

オンデバイスAIの最大の課題 ハードウェア性能の壁

ここまで聞くと「完璧じゃないか!」と思われるかもしれません。しかし、大きな制約が一つあります。

パソコンの性能が、使えるAIモデルの品質を決める

オンデバイスAIは、自分のパソコンのRAM(メモリ)とCPU性能に完全に依存します。

メモリ容量とモデルサイズの関係

一般的な目安:

| RAMメモリ | 推奨モデル | 性能レベル | 例 |

|---|---|---|---|

| 4GB以下 | 使用困難 | - | - |

| 8GB | 1-2bモデル | 基本的な会話 | qwen3:1.7b, gemma2:2b |

| 16GB | 3-7bモデル | 実用的な性能 | phi3:3.8b, mistral:7b |

| 32GB | 8-13bモデル | 高品質な応答 | llama3.1:8b |

| 64GB以上 | 20b以上 | 最高品質 | gpt-oss:20b |

最初の画面では、システムが「お使いのデバイスは最大3bパラメータのモデルを実行できます」と表示していました。これは、そのパソコンのRAMが8GB程度であることを示しています。

小さいモデルと大きいモデルの違い

1-3bパラメータのモデル(軽量)

メリット:

- ✅ 低スペックPCでも動作

- ✅ 応答が速い

- ✅ メモリ消費が少ない

デメリット:

- ❌ 複雑な質問への対応が弱い

- ❌ 長文の理解力が限定的

- ❌ 推論能力が基本的

- ❌ 日本語対応が不十分な場合あり

向いている用途:

- 簡単な質問応答

- 文章の要約

- シンプルなアイデア出し

- 辞書的な使い方

7-8bパラメータのモデル(中級)

メリット:

- ✅ 実用的な会話能力

- ✅ まともな推論ができる

- ✅ 複数言語対応

- ✅ コード生成も可能

デメリット:

- ❌ 16GB以上のRAMが必要

- ❌ やや応答が遅くなる

- ❌ 最新情報の学習が限定的

向いている用途:

- ビジネス文書の作成

- プログラミング支援

- 深い議論

- クリエイティブな文章生成

20bパラメータ以上のモデル(高性能)

メリット:

- ✅ GPT-4に迫る性能

- ✅ 高度な推論能力

- ✅ 専門的な知識

- ✅ 複雑なタスクに対応

デメリット:

- ❌ 32-64GB以上のRAMが必須

- ❌ 応答に時間がかかる

- ❌ CPUパワーも必要

- ❌ 一般的なPCでは動作が「限界的」

向いている用途:

- 専門的な分析

- 複雑なコード開発

- 学術的な議論

- 高度な創作活動

現実的な選択

8GBメモリのPCを持っている場合(最も一般的):

- 推奨: gemma2:2b または qwen3:1.7b

- 挑戦可能: phi3:3.8b(「限界的」だが動作する)

- 避けるべき: 7b以上のモデル(動作が遅すぎる、または起動不可)

16GBメモリのPCの場合:

- 推奨: mistral:7b または llama3:8b

- 快適: 3-7bモデル全般

- 挑戦可能: 13bモデル(メモリに余裕があれば)

32GB以上のPC(ハイエンド):

- すべてのモデルが選択肢に

- 20b以上の高性能モデルも実用可能

複数のAIモデルをダウンロードした場合 マルチエージェントは可能?

Gensparkでは、複数のAIモデルを同時にダウンロードして保存しておくことができます。この機能には大きな可能性があります。

モデルの使い分けができる

複数モデルをダウンロードしておくメリット:

1. タスクに応じた使い分け

軽い質問 → gemma2:2b(高速)

複雑な分析 → llama3.1:8b(高品質)

コード生成 → mistral:7b(コーディングに強い)

画像理解 → llava:7b(マルチモーダル)

2. メモリ状況に応じた選択

他のアプリを使用中 → 軽量モデル(2-3b)

AIだけ使うとき → 高性能モデル(7-8b)

マルチエージェントとしての可能性

現時点での情報では、複数モデルの「同時実行」や「協調動作」については明確にされていません。

しかし、技術的には以下のような使い方が考えられます:

パターン1: 順次実行型マルチエージェント

タスク:「この論文を分析して、要約とコメントを作成」

ステップ1: llama3:8b で論文を詳細分析

↓

ステップ2: mistral:7b で技術的評価

↓

ステップ3: gemma2:2b で簡潔な要約を作成

ユーザーが手動でモデルを切り替えながら、それぞれの得意分野を活かす使い方です。

パターン2: 比較検証型

同じ質問を複数のモデルに投げて、

回答の違いを比較することで、

より確実な答えを導き出す

これは特に、重要な判断をする際に有効です。

パターン3: 専門特化型

日本語の文章 → qwen3:1.7b(中国のモデルで日本語が得意)

英語の文章 → gemma2:2b(Google製で英語が得意)

コード → mistral:7b(コーディングに特化)

Gensparkブラウザでのマルチエージェント可能性

Gensparkブラウザには「オートパイロット」や「スーパーエージェント」機能があります。これらの機能が、バックエンドで複数のオンデバイスモデルを協調動作させている可能性があります。

例えば:

タスク:「この商品の最安値を見つけて、レビューも分析して」

Agent 1(軽量モデル): Webページの巡回とデータ収集

↓

Agent 2(高性能モデル): レビューの感情分析と要約

↓

Agent 3(中程度モデル): 結果の統合と推奨の作成

このような役割分担型のマルチエージェントが実装されていれば、効率的かつ高品質な結果が得られます。

現実的な活用方法

現時点で確実にできること:

モデルのライブラリを構築

- 様々なサイズ・特性のモデルをダウンロード

- 必要に応じて切り替えて使用

タスク別の最適化

- 速度重視のタスク → 軽量モデル

- 品質重視のタスク → 高性能モデル

リソース管理

- メモリに余裕があるとき → 大きいモデル

- 他の作業と並行 → 小さいモデル

フォールバック戦略

- メインモデルが重すぎる場合の代替

- 特定のタスクで失敗したときの別選択

オンデバイスAI vs クラウドAI どちらを選ぶべきか?

オンデバイスAIが向いている人

✅ プライバシーを最重視する

- 医療、法律、財務などの専門職

- 企業機密を扱うビジネスパーソン

- 個人情報保護に敏感な人

✅ オフライン環境で使いたい

- 頻繁に移動する人

- 通信環境が不安定な地域

- 通信コストを削減したい

✅ 長期的なコスト削減

- サブスクリプションを避けたい

- 初期投資(ハイスペックPC)ができる人

✅ 16GB以上のRAMを持つPC所有者

- 快適に中〜高性能モデルを使える

クラウドAIが向いている人

✅ 最高品質のAIを使いたい

- GPT-4、Claude 3.5 Sonnet、Gemini Ultra

- オンデバイスの20bモデルでも敵わない性能

✅ 低スペックPCしか持っていない

- 8GB以下のメモリ

- 古いPC・ノートパソコン

✅ 常にインターネット接続がある

- オフィスワーカー

- 自宅作業中心

✅ 最新情報が必要

- リアルタイム検索機能

- 最新ニュース・データへのアクセス

ハイブリッド戦略(推奨)

最も賢い使い方は、両方を使い分けることです:

日常的な質問・簡単なタスク

→ オンデバイスAI(無料・高速・プライベート)

重要な分析・複雑なタスク

→ クラウドAI(高性能・最新情報)

センシティブな内容

→ オンデバイスAI(完全プライバシー)

画像生成・音声合成など

→ クラウドAI(専門特化サービス)

PCアップグレードを考えるべきか?

オンデバイスAIを本格的に活用したいなら、メモリ増設は最もコスパの良い投資です。

アップグレードの効果

| 現在のメモリ | 増設後 | 追加コスト(目安) | 効果 |

|---|---|---|---|

| 8GB | 16GB | 5,000-8,000円 | 7-8bモデルが快適に |

| 16GB | 32GB | 10,000-15,000円 | 13bモデルまで実用的 |

| 32GB | 64GB | 20,000-30,000円 | 20b以上も可能 |

月額3,000円のAIサブスクリプションと比較すると:

- 16GBへの増設: 2-3ヶ月で元が取れる

- 32GBへの増設: 4-5ヶ月で元が取れる

しかも、一度投資すれば永久に使えるのです。

増設できないPC(ノートパソコンなど)の場合

最新のノートPCの中には、メモリが基板に直付けで増設不可能な機種もあります。その場合:

軽量モデルに特化する

- gemma2:2b、qwen3:1.7bを活用

- 速度と基本性能のバランスを取る

ハイブリッド戦略を徹底する

- 簡単なタスクはオンデバイス

- 複雑なタスクはクラウドAI

次回PC購入時にメモリ重視

- 最低16GB、できれば32GB搭載機種を選ぶ

まとめ オンデバイスAI

Genspark オンデバイスAIは、AIの民主化とプライバシー保護において革命的な一歩です。

素晴らしい点

- ✅ 完全なプライバシー保護

- ✅ オフラインでの自由な利用

- ✅ 永久無料

- ✅ 高速レスポンス

- ✅ 169の多様なモデル

現実的な制約

- ⚠️ PC性能に大きく依存

- ⚠️ 高性能モデルには高スペックPCが必須

- ⚠️ 低スペックPCでは基本的なモデルのみ

- ⚠️ クラウドAIの最高性能には及ばない(現時点)

これからの展望

AI技術は急速に進化しています。モデルの小型化・効率化も進んでおり、将来的には:

- より小さいパラメータで高性能を実現

- 省メモリ技術の向上

- GPU利用の最適化

- 量子化技術による軽量化

これらが実現すれば、普通のPCでも高性能AIが動く時代が来るでしょう。

導入ステップ

- まず試してみる: 現在のPCでどのモデルが動くか確認

- 使い分けを学ぶ: オンデバイスとクラウドの適材適所

- 長期的視点: 次回PC購入時はメモリ容量を重視

- プライバシー意識: センシティブな内容はオンデバイスで

Genspark オンデバイスAIは、完璧ではありませんが、AIとの付き合い方に新しい選択肢を与えてくれる画期的な技術です。自分のPC性能と使用目的に合わせて、賢く活用してみてください。

この記事は2026年2月の情報に基づいています。Gensparkの機能やモデルのラインナップは今後も進化していく可能性があります。